رباتها میتوانند کاربردهای خوب یا بد داشته باشند، اما در هر دو حالت باید از ورود ترافیک رباتها به گوگل آنالیتیکس جلوگیری کنید. در Google Analytics 4، ترافیک رباتهای شناختهشده به صورت خودکار مسدود میشود.

با این حال، لازم است گزارشهای خود را به طور منظم بررسی کنید تا هرگونه رفتار غیرعادی یا مشکوک به ربات را شناسایی کنید.

برای جلوگیری از انحراف دادهها، میتوانید هم در داخل اکانت آنالیتیکس ۴ و هم در خارج از آن اقداماتی انجام دهید. بهترین راه برای حفظ دقت گزارشها و پاک نگه داشتن دادهها از ترافیک رباتها این است که فرایند «بازبینی کیفیت داده» را به طور مستمر در جریان کاری خود اجرا کنید. در ادامه این مطلب با آموزش شناسایی ترافیک ربات ها در آنالیتیکس ۴ و حذف آنها همراه من باشید.

منظور از ترافیک ربات چیست؟

ترافیک ربات شامل تمام بازدیدهایی است که از سوی انسانها انجام نمیشود. رباتها در واقع برنامههایی هستند که با اهداف خوب یا بد ساخته میشوند. در هر حال، شما نمیخواهید این نوع ترافیک را به اشتباه به عنوان بازدید کاربران واقعی یا مخاطبان هدف خود در نظر بگیرید.

همه رباتها کاربرد خوبی ندارند، اما بدون شک تعدادشان در فضای وب بسیار زیاد است. بر اساس یک مطالعه، در سال ۲۰۲۲ حدود ۴۷ درصد از کل ترافیک وب در جهان توسط رباتها ایجاد شده است.

لحظهای مکث کنید و به این عدد فکر کنید. یعنی در سال ۲۰۲۲ فقط ۵۲ درصد از ترافیک اینترنت واقعا توسط انسانها بوده است.

برای اینکه بهتر بدانید در گوگل آنالیتیکس با چه چیزی روبهرو هستید، بیایید نگاهی بیندازیم به انواع رباتهایی که میتوانند وارد سایت شما شوند و گزارشهایتان را دچار انحراف کنند.

۳ نمونه از رباتهای مخرب

رباتهای مخرب در اشکال مختلفی وجود دارند و میتوانند به روشهای غیرمنتظرهای به سایت شما آسیب بزنند.

۱. رباتهای دلال (Scalper Bots)

این رباتهای زیرک، بلیتها یا محصولات خاص را بهصورت خودکار خریداری میکنند تا بعدها آنها را با قیمت بالاتر بفروشند. در ظاهر ممکن است فروش سریع محصولات گرانقیمت جذاب به نظر برسد، اما در واقعیت، این کار میتواند به شدت به اعتبار برند شما آسیب بزند. هیچ کاربری دوست ندارد از رباتها شکست بخورد.

۲. رباتهای اسپم (Spam Bots)

این رباتها در مزاحمت مهارت دارند. مثلا میتوانند در مدت زمان بسیار کوتاهی بخش نظرات وبلاگها را با پیامهای بیربط یا تبلیغاتی پر کنند، سریعتر از آنکه شما بتوانید آنها را حذف کنید.

۳. رباتهای کپیبردار (Scraper Bots)

این برنامهها در مقیاس وسیع از محتوای وبسایتها سرقت میکنند. هدف اصلی آنها اغلب کپیکردن محتوای رقبا و آسیبزدن به آنها در مراحل بعدی است.

۳ نمونه از رباتهای مفید

رباتهای مفید میتوانند به رشد کسبوکارها کمک کنند. آنها کارهای تکراری را در کسری از ثانیه انجام میدهند و دادههای عظیمی را جمعآوری میکنند که در حالت عادی ممکن است روزها یا حتی ماهها طول بکشد.

۱. خزندههای وب یا رباتهای موتور جستجو (Web Crawlers / Search Engine Bots)

رباتهای گوگل (Googlebots) پیشرفتهترین نمونهها هستند. آنها به طور مداوم اینترنت را برای یافتن تصاویر، ویدیوها، متون، لینکها و سایر محتواها بررسی میکنند. بدون این رباتها، سایت شما هیچ بازدیدی از سرچ ارگانیک دریافت نمیکرد.

۲. رباتهای بررسی بکلینک (Backlink Checkers)

این برنامهها کمک میکنند تا تمام لینکهایی که از سایر سایتها به وبسایت شما داده شده شناسایی شوند. ابزارهای ضروری برای متخصصان سئو هستند.

۳. رباتهای پایش سایت (Website Monitoring Bots)

این رباتها وضعیت سایت را زیر نظر دارند و مثلا در صورتی که سایت مورد حمله هکری قرار گیرد یا از دسترس خارج شود، بلافاصله مالک را مطلع میکنند.

آیا گوگل آنالیتیکس ۴ ترافیک رباتها را مسدود میکند؟

بله، نسخه GA4 ترافیک رباتهای شناختهشده را به طور خودکار مسدود میکند. برای شناسایی رباتهای خوب و بد، از دو منبع اصلی استفاده میکند:

اول، تحقیقات داخلی گوگل؛

و دوم، فهرست بینالمللی IAB/ABC Spiders and Bots List که به صورت ماهانه بهروزرسانی میشود.

از زمان معرفی Google Analytics 4، اوضاع به شکل محسوسی بهتر شد و حجم ترافیک اسپم در گزارشها کاهش پیدا کرد. اما باید توجه داشت که اسپم تنها یکی از انواع ترافیک رباتی است که میتواند دادههای شما را آلوده کند.

انواع مختلفی از رباتها دائما سایتها را اسکن، خزیده یا حتی مورد حمله قرار میدهند. و گاهی خود ما هم بهطور ناخواسته رباتهایی را به سمت سایتمان میفرستیم.

چطور ترافیک رباتها را در آنالیتیکس ۴ شناسایی کنیم؟

برای شناسایی ترافیک ربات در GA4 باید به دنبال دادههای غیرعادی بگردید. منظور دادههایی است که بهطور کامل با الگوی کلی گزارشهای شما تفاوت دارند.

فرض کنید در گزارش خود جدولی میبینید که در یک سشن بیش از ۱۰ هزار ایونت ثبت شده، اما نرخ تعامل (Engagement Rate) صفر درصد است. این دقیقا نشانهای از حضور رباتهاست.

در ادامه، مهمترین نشانههایی را مرور میکنیم که به شما کمک میکند ترافیک غیرانسانی را در گزارشهای گوگل آنالیتیکس تشخیص دهید.

۱. منبع ترافیک «دایرکت» یا «Unassigned»

گوگل سعی میکند منبع هر بازدید را به یکی از کانالهای شناختهشده (مثل Organic، Paid، Email و…) نسبت دهد. این بخش را میتوانید در گزارش Traffic Acquisition ببینید.

اما رباتها معمولا از مسیرهای ناشناخته یا مستقیم وارد سایت میشوند و به همین دلیل در گزارشها به عنوان ترافیک دایرکت یا Unassigned نمایش داده میشوند.

اگر در این بخش سشن هایی با نرخ تعامل پایین میبینید، احتمال حضور رباتها زیاد است.

بیشتر بخوانید: افزایش ترافیک دایرکت در آنالیتیکس

۲. افزایش ناگهانی در نرخ تبدیل (Conversions)

کانورژن ها یکی از مهمترین شاخصها در GA4 هستند، چون نشان میدهند که آیا سایت در مسیر درستی برای دستیابی به اهداف نهاییقرار دارد یا نه.

اما گاهی رباتها باعث میشوند آمار کانورژن های شما غیرواقعی به نظر برسد.

مثلا ممکن است فرمها را بهصورت خودکار پر کنند و این تصور را ایجاد کنند که سایت شما سرنخهای واقعی (Leads) تولید کرده است.

پس اگر در گزارشهای Conversion یا Monetization با دادههای مشکوک مواجه شدید، حتما آنها را دقیقتر بررسی کنید.

۳. منابع یا ریفرال مشکوک (Suspicious Sources and Referrals)

بعضی توسعهدهندگان حتی تلاشی برای پنهانکردن منبع ترافیک رباتهایشان نمیکنند و این ترافیک معمولا بهسرعت در فهرست رباتهای مسدودشده قرار میگیرد.

اما برخی دیگر بهراحتی از فیلترها عبور میکنند و به سرعت ظاهر میشوند.

برای شناسایی این منابع، وارد مسیر Reports > Acquisition > Traffic Acquisition شوید و بعد، ستون اصلی را به Source/Medium تغییر دهید.

در اینجا به دنبال دادههایی باشید که تعداد کاربران بالا اما میانگین زمان تعامل بسیار پایین دارند.

۴. نرخ پرش بالا (High Bounce Rate)

البته نرخ پرش یا بانس ریت بالا همیشه نشانه بدی نیست، اما اگر صفحاتی دارید که نرخ تعامل بالایی از آنها انتظار دارید و با این حال نرخ پرش بالایی دارند، باید شک کنید.

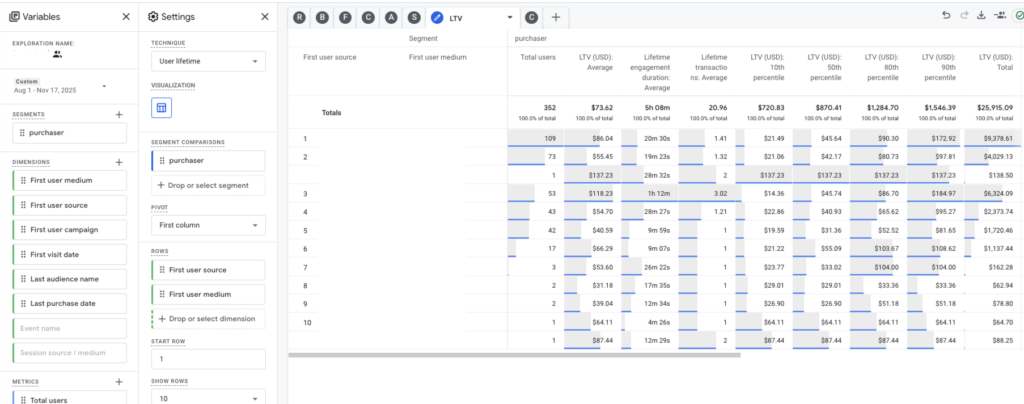

میتوانید یک گزارش در اکسپلور (Exploration) در GA4 بسازید که شبیه گزارش Entrances باشد اما از شاخص Bounce استفاده کند تا منشا این رفتار را پیدا کنید.

۵. سشن با تعامل پایین (Low Engagement Sessions)

در GA4 شاخصی داخلی به نام Engaged Sessions وجود دارد که نشان میدهد کاربران چقدر با سایت تعامل دارند.

سشن هایی با نرخ تعامل پایین معمولا مربوط به رباتها هستند.

میتوانید از این شاخص برای ساخت Audience Segment استفاده کنید و دادههای مشکوک را در گزارشهای اکسپلور جدا کنید.

البته این روش کاملا دقیق نیست، چون ممکن است شامل کاربران واقعی هم بشود.

۶. نرخ تعامل پایین (Low Engagement Rate)

بهطور کلی، تمام شاخصهای تعامل در مقابله با ترافیک ربات مفید هستند. انسانها رفتار متفاوتی نسبت به برنامههای خودکار دارند.

میتوانید این شاخصها را در گزارشهای پیشفرض GA4 ببینید یا در گزارشهای سفارشی خود به کار بگیرید.

۷. زمان تعامل صفر (Zero Engagement Time)

هرچه یک ربات سریعتر کار خود را انجام دهد، برای صاحب آن بهتر است. رباتها فقط وارد سایت میشوند، داده جمع میکنند یا اسپم ارسال میکنند و بلافاصله خارج میشوند.

اگر در گزارشها سشن هایی میبینید که زمان تعامل آنها صفر یا فقط چند میلیثانیه است، تقریبا مطمئن باشید با ترافیک رباتی مواجه هستید.

۸. ترافیک مشکوک از شهرها یا کشورها

اگر ناگهان شاهد افزایش بازدید از شهرها، مناطق یا کشورهایی هستید که تا کنون آنها را تارگت نکرده اید، عجله نکنید و به فکر جشن گرفتن نیفتید.

میتوانید اطلاعات لوکیشن کاربران را در مسیر Reports > User Attributes > Overview مشاهده کنید تا لوکیشن های مشکوک را تشخیص دهید.

چطور ترافیک رباتها را از گزارشهای آنالینیکس ۴ حذف کنیم؟

هیچکس نمیتواند تضمین کند که گزارشهای شما در GA4 کاملا عاری از ترافیک ربات باشند.

برای مقابله با رباتها باید همیشه هوشیار باشید، نه اینکه صرفا به فیلترهای خودکار گوگل اعتماد داشته باشید.

دلیلش ساده است:

وقتی دادههای رباتها وارد گزارشهای شما شوند، بعدا آنها را نمیتوانید حذف کنید. بنابراین باید از همان ابتدا پیشگیری کنید تا این ترافیک وارد دادههای شما نشود. در ادامه، چند روش کاربردی برای جلوگیری از ورود ترافیک رباتها به حساب GA4 را مرور میکنیم.

۱. استفاده از نرمافزارهای امنیتی و محافظت وبسایت

ابزارهایی مثل CDN، فایروال وبسایت و افزونههای امنیتی میتوانند جلوی ورود رباتها را بگیرند.

این ابزارها در واقع ترافیکی را مسدود میکنند که ممکن است گوگل آنالیتیکس قادر به شناسایی آن نباشد.

در نتیجه، دادههایی که وارد گزارشهای شما میشوند تمیزتر و دقیقتر خواهند بود.

۲. مسدود کردن رباتها در فایل robots.txt

برای استفاده از این روش باید از دولوپرها کمک بگیرید. فایل robots.txt یکی از سادهترین روشها برای جلوگیری از دسترسی برخی رباتها به سایت است، و در نتیجه باعث میشود این ترافیک وارد گوگل آنالیتیکس نشود.

البته نباید بیش از حد روی این روش حساب کنید، چون رباتهای مخرب معمولا اهمیتی به این محدودیت نمیدهند.

با این حال، استفاده از robots.txt میتواند به کاهش مصرف منابع سرور کمک کند. در واقع، وقتی رباتهای بیفایده را مسدود کنید، عملکرد سایت نیز بهتر میشود. برای بررسی تأثیر این اقدام، میتوانید سرعت سایت را از طریق گزارشهای سرعت سایت در آنالیتیکس ۴ بررسی کنید.

۳. فیلتر کردن ترافیک رباتها بر اساس آدرس IP

روشهای مختلفی برای شناسایی IP رباتها وجود دارد، اما معمولا باید خارج از GA4 انجام شوند.

به عنوان مثال، میتوانید از تیم فنی بخواهید تا لاگهای سرور را بررسی کند، یا از افزونههای ضداسپم استفاده کنید تا IP رباتها را شناسایی کنند.

اما یک نکته مهم را در نظر داشته باشید:

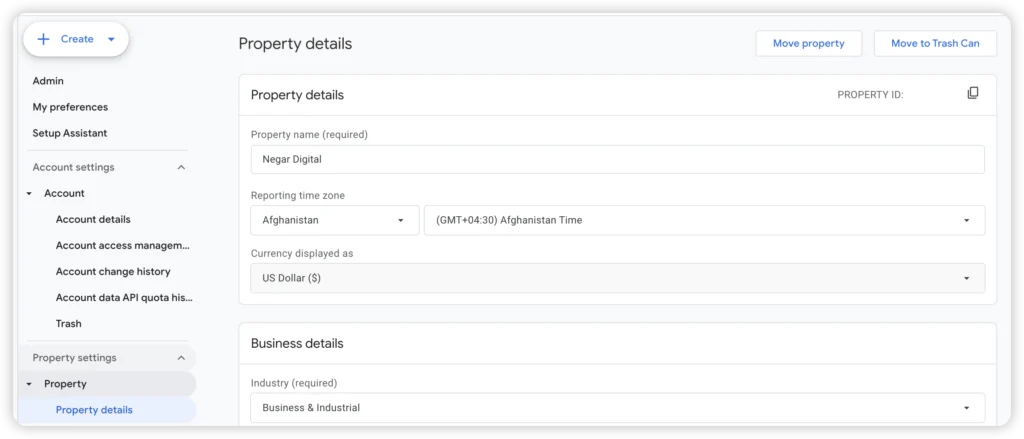

به دلیل قوانین حریم خصوصی و GDPR، در GA4 امکان محدود کردن ترافیک داخلی از طریق ثبت IPها وجود دارد.

هرچند این قابلیت در اصل برای فیلتر کردن ترافیک داخلی طراحی شده، میتوانید از آن برای مسدود کردن IP اسپمرها هم استفاده کنید تا دادههایشان وارد گزارش نشود.

۴. شخصیسازی تنظیمات GA4

بسته به نوع ترافیک مشکوکی که در گزارشهای خود مشاهده میکنید، میتوانید از تنظیمات مختلف برای بررسی دادهها استفاده کنید.

بهصورت کلی، این مرحله شامل سفارشیسازی گزارشها و ساخت فیلترهای هدفمند است.

در اینجا چند روش مؤثر را معرفی میکنم:

- ایجاد Audience Segment برای مناطق جغرافیایی مشکوک؛

- استفاده از Comparisons برای فیلتر کردن دادههای ناخواسته در گزارشها؛

- ساخت گزارشهای Exploration که ترکیبی از شاخصهایی مثل بانس ریت، نرخ تعامل یا مدتزمان سشن را نشان میدهند تا ترافیک ربات راحتتر شناسایی شود؛

- شخصیسازی گزارشهای پیشفرض GA4 و ذخیره آنها برای استفاده شخصی یا تیمی تا همه افراد با دادههای تمیزتر و دقیقتر کار کنند.

چرخه بازبینی کیفیت داده در آنالیتیکس ۴

بسیاری از کاربران گوگل آنالیتیکس فراموش میکنند که این ابزار از نوع «راهاندازی و فراموش کن» نیست. اگر میخواهید تصمیمهای خود را بر پایه داده بگیرید، باید مطمئن شوید دادههایتان تمیز هستند و همینطور تمیز باقی میمانند.

فیلتر کردن ترافیک رباتها یک تنظیم ساده نیست، بلکه بخشی از یک فرایند دائمی است که به آن چرخه بازبینی کیفیت داده گفته میشود.

این چرخه از پنج مرحله تشکیل شده است:

- تحلیل ترافیک در گزارشها

ابتدا باید دادهها و الگوهای رفتاری کاربران را در گزارشهای خود بررسی کنید. - شناسایی ناهنجاریها (Anomalies)

در مرحله بعد، به دنبال دادههای غیرعادی یا رفتارهای مشکوک بگردید که با سایر بخشهای گزارش تفاوت دارند. - یافتن علت ناهنجاریها

پس از شناسایی مشکل، باید ریشه آن را پیدا کنید؛ مثلا آیا ورودی یک کمپین اشتباه است، یا ورود رباتها باعث آن شده؟ - رفع مشکل

زمانی که علت را پیدا کردید، اقدام اصلاحی لازم را انجام دهید، مثلا فیلتر جدید بسازید، تنظیمات را اصلاح کنید یا منبع ترافیک را مسدود کنید. - ثبت و مستندسازی ایرادها

در نهایت، ایرادها و اقداماتی که انجام دادهاید را با ابزارهایی مثل Annotations یا گزارشهای داخلی مستند کنید تا در آینده قابل پیگیری باشند.

و بعد… این چرخه دوباره تکرار میشود. شما باید به طور مداوم گزارشها را بررسی کنید تا ببینید آیا ترافیک مشکوک جدیدی وارد نشده است یا نه.

تحلیل داده همیشه همراه با انتظار است؛ باید صبر کنید تا دادهها جمعآوری شوند و بتوانید نتایج را ارزیابی کنید.

دادههای خود را دوباره بررسی کنید، یک روز، یک هفته یا یک ماه بعد، تا مطمئن شوید راهحلهایی که اعمال کردهاید مؤثر بودهاند.

نکته مثبت این است که GA4 میتواند از طریق ایمیل شما را از بروز اتفاقات عجیب و غیر قابل انتظار در سایت آگاه کند. اگر موردی غیرعادی دیدید، حتما بررسی دقیق انجام دهید.

با استفاده از این چرخه، میتوانید در آینده کیفیت دادههای خود را حفظ کنید و مطمئن باشید تصمیمهایی که میگیرید بر اساس دادههای واقعی و قابل اعتماد است.